Vieses na Inteligência Artificial (IA) é uma anomalia de algoritmos do aprendizado de máquina. Essa anomalia tem sido estudada muito nos últimos anos conforme o conhecimento da IA cresceu. Tem se apresentado como uma área crítica de pesquisa e preocupação nos círculos de aprendizado de máquina e cresceu em conscientização entre o público de consumidores.

É um termo que descreve situações em que os sistemas de análise de dados que mostram preconceitos contra certos grupos de pessoas durante o processo de desenvolvimento do algoritmo e dados de treinamento. Esses preconceitos geralmente refletem preconceitos sociais generalizados sobre raça, gênero, sexo biológico, idade e cultura.

Entre os tipos principais de vieses da Inteligência Artificial, podemos citar dois muito abordados: o “viés de dados”, em que os algoritmos são treinados usando dados tendenciosos; e o de preconceito da Inteligência Artifical social, em que nossas suposições e normas como sociedade fazem com que tenhamos pontos cegos ou certas expectativas em nosso pensamento. Assim, causa uma Inteligência Artificial programada desta forma comporta-se de maneiras que refletem intolerância social ou discriminação institucional. À primeira vista, os próprios algoritmos e dados podem parecer imparciais, mas sua saída reforça os preconceitos sociais.

A inteligência artificial tem potencial para fazer o bem no mundo. Mas quando é construído com base em dados e suposições tendenciosas, pode prejudicar a maneira como as pessoas vivem, trabalham e progridem em suas vidas. Podemos lutar contra esses preconceitos estando em sintonia com os preconceitos do mundo em que vivemos e desafiando as suposições que sustentam os conjuntos de dados com os quais estamos trabalhando e os resultados que eles oferecem. Podemos começar lendo amplamente, engajando-nos com ideias progressistas e compartilhando artigos e pesquisas úteis que podem ser usados para educar outras pessoas, por exemplo.

A IA algum dia será completamente imparcial?

A melhor reposta para essa pergunta é tecnicamente sim, e na prática complexa. Isso porque um sistema de Inteligência depende da qualidade do input dos dados de entrada. Nessa entrada já subjetividade, conjunto de dados de treinamento que podem trazer suposições equivocadas em alguns casos, levando a possíveis vieses, dificultando a parcialidade dos resultados. Há diversos tipos de preconceitos humanos que podem contaminar a entrada de resultados para a automação de um processo pela inteligência artificial. Essa é a maior dificuldade da IA ser completamente imparcial, já que pode não ser possível ter uma mente humana completamente imparcial, devido a dados tendenciosos criados por hunamos. A realização de testes consntantes e boas práticas contra esses vieses, são formas de minimizar a parcialidade.

A tecnologia não é imparcial: os algoritmos são processos matemáticos e são as pessoas quem os constroem. É muito comum vemos situações envolvendo soluções de de tecnologias de Inteligência Artificial que apresentam vieses sexistas, racistas, discriminatórios, como aplicativos que focam apenas em mulheres magras e bonitas, fotos de pessoas destacando apenas pessoas de uma classe social mais privilegiada e polêmica de mídias sociais envolvendo a objetificação do corpo humano.

Exemplos vieses da IA na vida real

- Muitos estudos de pesquisa, como os da área de psicologia inclui resultados de alunos de graduação que são um grupo específico e não representam toda a população.

- Em 2019, o Facebook estava permitindo que seus anunciantes direcionassem seus anúncios intencionalmente de acordo com sexo, raça e religião. Por exemplo, as mulheres foram priorizadas em anúncios de empregos para funções de enfermagem ou secretariado, enquanto os anúncios de empregos para zeladores e motoristas de táxi foram exibidos principalmente para homens, em particular homens oriundos de minorias. Como resultado, o Facebook não permitirá mais que os empregadores especifiquem a segmentação por idade, sexo ou raça em seus anúncios

- Reconhecimento facial da Amazon: antes dos protestos nacionais sobre a morte de George Floyd em 2020, nos Estados Unidos, a Amazon ganhou dinheiro com seu software de reconhecimento facial e o vendeu para departamentos de polícia, mesmo quando pesquisas mostraram que programas de reconhecimento facial identificam falsamente pessoas de cor em comparação com pessoas brancas, e também que seu uso pela polícia pode resultar em uma prisão injusta que afetará amplamente os negros. A Amazon interrompeu a distribuição de software de reconhecimento facial para departamentos de polícia em junho passado. Os engenheiros da computação têm lutado contra o uso histórico de termos de codificação que incluem racismo como “mestre” e “escravo”, enquanto alguns defendem uma linguagem mais neutra.

- No problema seguinte, a escolha equivocada de dados de entrada, que incluem apenas imagens de cachorros pretos e de gatos claros, resultado no reconhecimento de um cachorro branco como gato, com confiança de 96%:

Fonte: Inteligências Artificiais, preconceitos reais

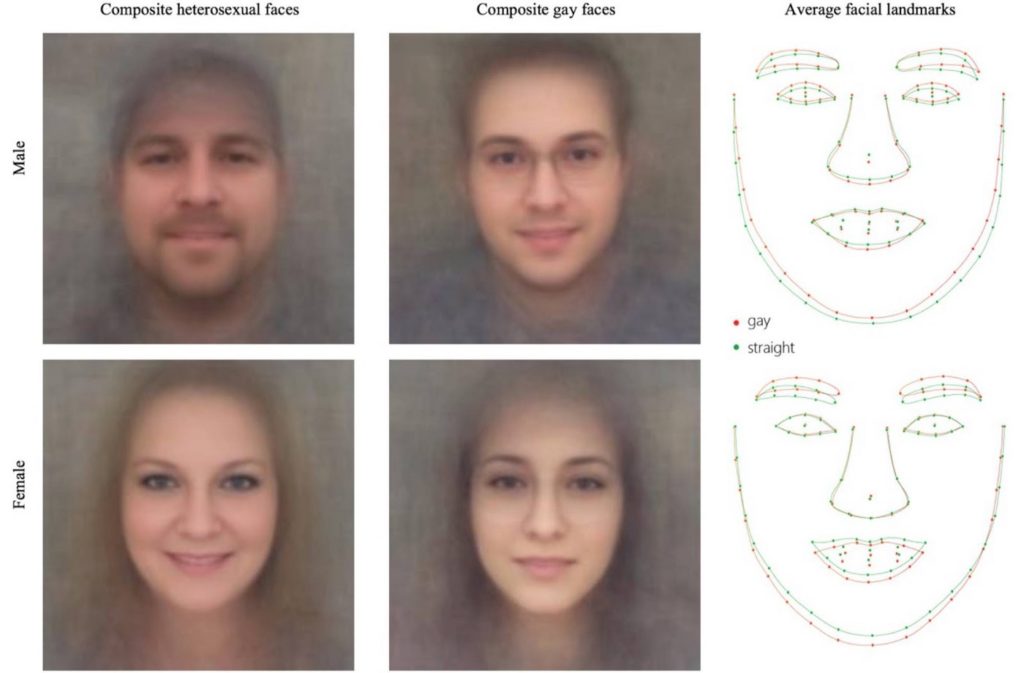

- No problema seguinte, um polêmico estudo da Universidade de Stanford que defende dimorfismo facial como base para a criação de uma inteligência artificial supostamente capaz de determina a orientação sexual de uma pessoa. Um exemplo de mathwashing, uma crença amplamente difundida de que, como a matemática está envolvida, os algoritmos são automaticamente neutros. Esse equívoco generalizado permite que o preconceito não seja controlado e permite que as empresas e organizações evitem a responsabilidade escondendo-se atrás de algoritmos.

Arrasou!!! Muito bem escrito, bem embasado e trás reflexões muito importantes sobre a forma de atuação do algoritmo!!! Super recomendo.